Google продолжают экспериментировать к архитектурами: они выпустили T5Gemma

Большинство современных LM – это decoder-only трансформеры. А T5, напротив, – полноценная encoder-decoder архитектура.

Причем обучали ее не с нуля, а с помощью уже предобученной Gemma-2, которая как раз decoder-only. Веса сначала просто инициализировали с помощью Gemma-2, а затем адаптировали методом UL2.

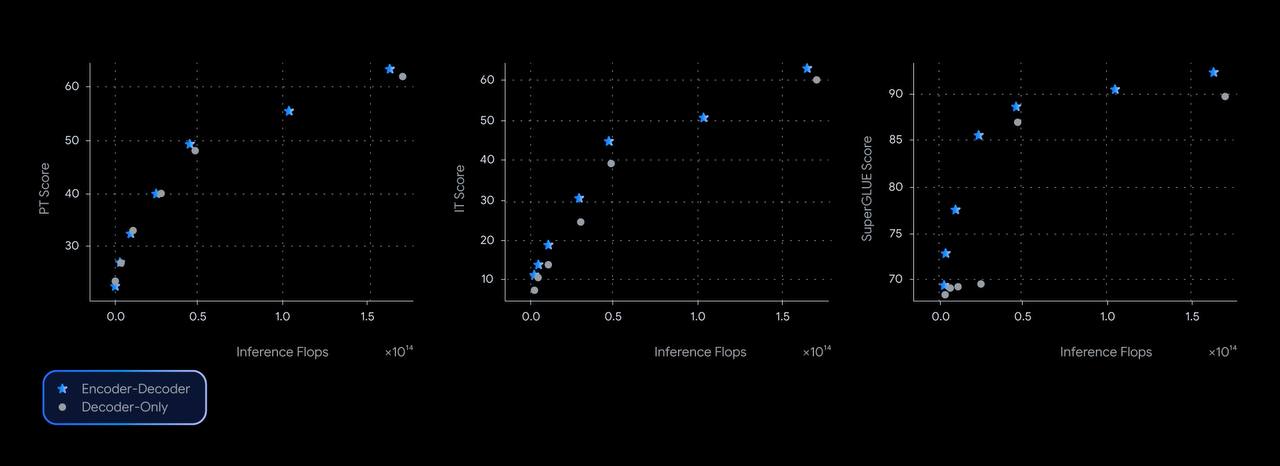

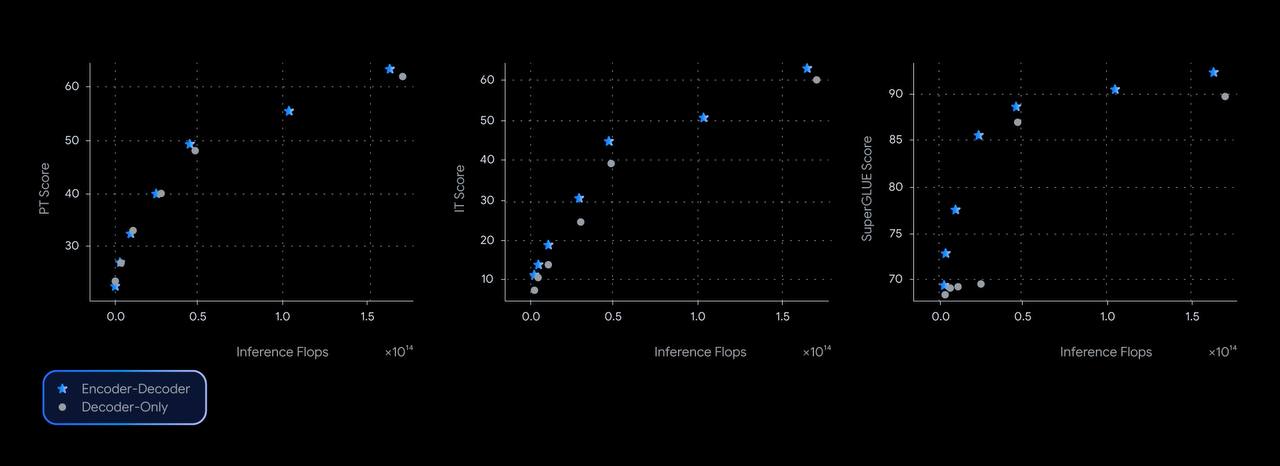

Интересна архитектура тем, что можно гибко подбирать размер модели. Взял энкодер на 9В и декодер на 2В – получил модель побольше, поменял энкодер – и сделал ее поменьше. Так же можно регулировать баланс между метриками и тяжеловесностью (см таблицу 2 и 3).

Перформит на достойном уровне. Веса доступны тут, а вот блогпост

Большинство современных LM – это decoder-only трансформеры. А T5, напротив, – полноценная encoder-decoder архитектура.

Причем обучали ее не с нуля, а с помощью уже предобученной Gemma-2, которая как раз decoder-only. Веса сначала просто инициализировали с помощью Gemma-2, а затем адаптировали методом UL2.

Интересна архитектура тем, что можно гибко подбирать размер модели. Взял энкодер на 9В и декодер на 2В – получил модель побольше, поменял энкодер – и сделал ее поменьше. Так же можно регулировать баланс между метриками и тяжеловесностью (см таблицу 2 и 3).

Перформит на достойном уровне. Веса доступны тут, а вот блогпост