Новая архитектура Mamba-3 делает модели быстрее, стабильнее и эффективнее при работе с длинными контекстами, потенциально знаменуя собой начало конца эпохи Transformers.

Главная идея Mamba-3 заключается в использовании state-space моделей, где модель хранит и обновляет внутреннее состояние во времени, в отличие от слоев внимания, используемых в Transformers.

Краткий экскурс в историю Mamba:

В Mamba-3 аппроксимируется интеграл обновления состояния не только по правому концу интервала, но и усреднением между началом и концом, с коэффициентом λ, зависящим от данных. Это обеспечивает более точное приближение и делает динамику состояния более выразительной.

Что изменилось под капотом:

Практическое применение:

Mamba-3 — это не просто ускоренная альтернатива Transformers, а новая архитектура, объединяющая глубокое понимание контекста, скорость и устойчивость, подходящая для различных применений, от серверных систем до умных устройств.

Главная идея Mamba-3 заключается в использовании state-space моделей, где модель хранит и обновляет внутреннее состояние во времени, в отличие от слоев внимания, используемых в Transformers.

State-space модели (SSM) — это математические модели, описывающие динамические системы, изменяющиеся во времени. Они используются для представления и анализа поведения различных систем, от физических до экономических.

Краткий экскурс в историю Mamba:

- Mamba-1 представила непрерывную динамику и выборочное обновление памяти, обеспечивая эффективное запоминание без высокой вычислительной стоимости attention.

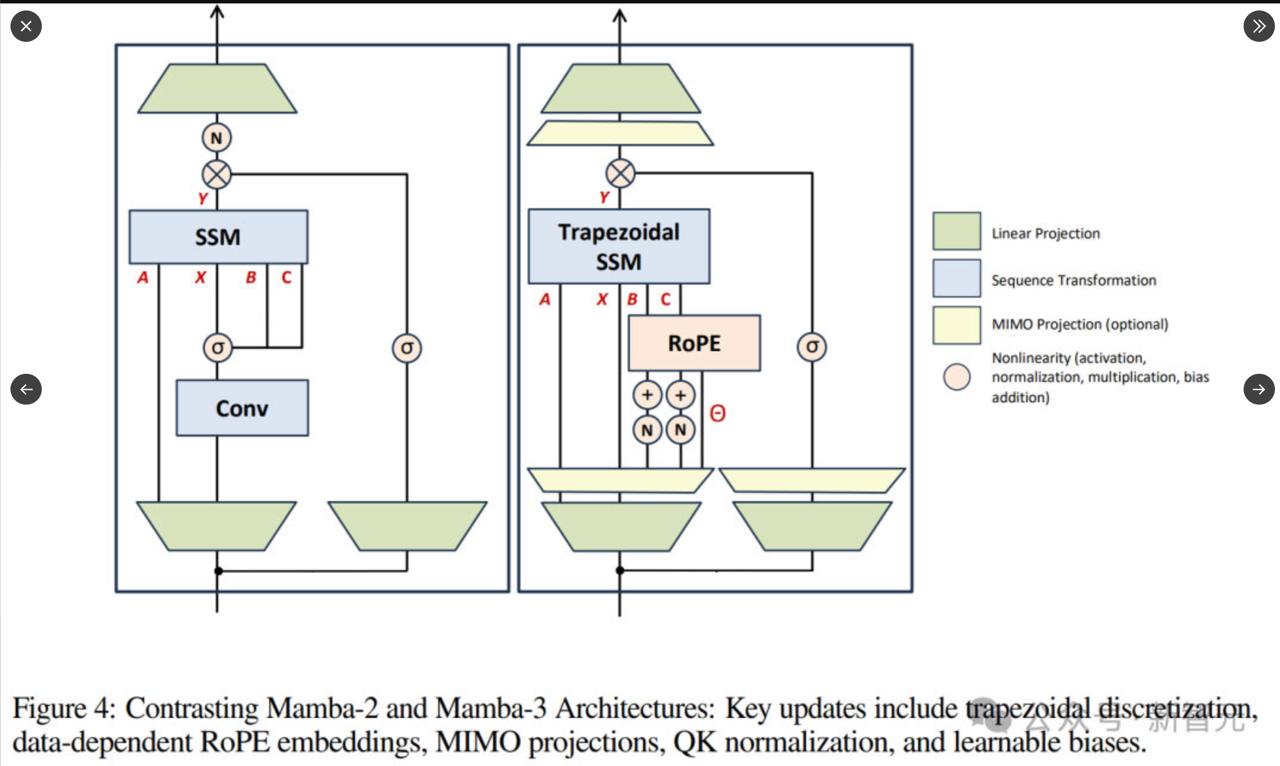

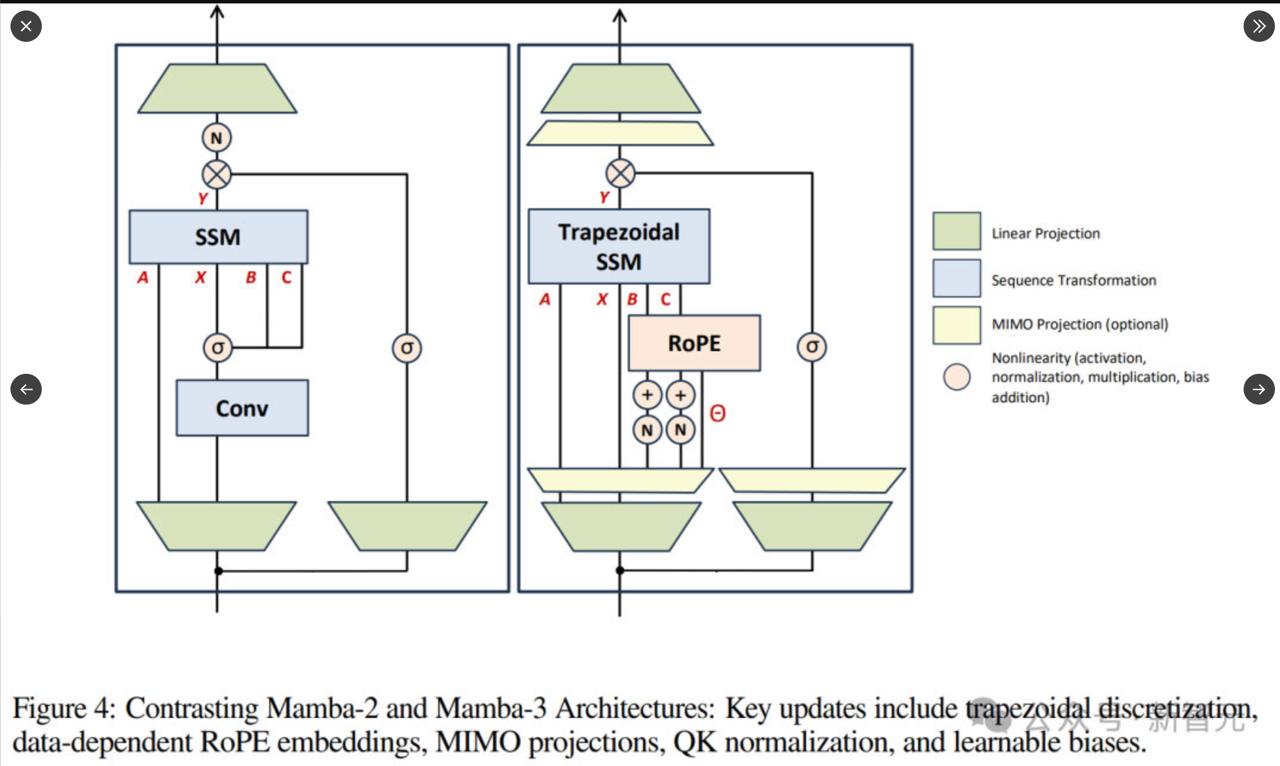

- Mamba-2 показала, что обновления состояния и attention — это две стороны одной математической медали, что ускорило вычисления на GPU.

- Mamba-3 довела концепцию до зрелости: теперь внутренняя память развивается плавнее и устойчивее за счёт перехода от простого шага Эйлера к трапецеидальному интегрированию.

В Mamba-3 аппроксимируется интеграл обновления состояния не только по правому концу интервала, но и усреднением между началом и концом, с коэффициентом λ, зависящим от данных. Это обеспечивает более точное приближение и делает динамику состояния более выразительной.

Что изменилось под капотом:

- Память стала «ритмичной»: теперь модель может хранить повторяющиеся и периодические паттерны, такие как структуры языка или музыки.

- Новый multi-input-multi-output дизайн позволяет обрабатывать несколько потоков параллельно, что идеально подходит для современных GPU.

Практическое применение:

- Эффективная работа с длинными последовательностями: документами, геномами, временными рядами.

- Линейное время выполнения и стабильная задержка делают её идеальной для работы в реальном времени: чат-ботов, перевода, речи.

- Энергоэффективность и масштабируемость открывают путь к on-device AI, где большие модели работают локально, без облака.

Mamba-3 — это не просто ускоренная альтернатива Transformers, а новая архитектура, объединяющая глубокое понимание контекста, скорость и устойчивость, подходящая для различных применений, от серверных систем до умных устройств.