Seed-Coder 8B – новая большая языковая модель (LLM) для кодинга от китайской компании ByteDance. Она превосходит даже недавнюю модель Qwen 3 в задачах, связанных с кодом, но не конкурирует в других областях. Разработчики обучили как instruct-модель, так и модель для логических рассуждений (ризонер).

Особенностью является то, что модель обучена всего на 6 триллионах токенов, что относительно мало, учитывая, что датасеты лучших открытых моделей часто превышают 30 триллионов токенов.

Ключевым элементом обучения является "model-centric" пайплайн. Специальные LLM-фильтры оценивают качество кода (читаемость, модульность и другие аспекты) из GitHub и веб-источников, отсеивая примеры низкого качества. Таким образом, отфильтровывается около 2.3 триллиона токенов данных. Затем модель обучается на 6 триллионах токенов, что вызывает небольшое недоумение. Вероятно, некоторые данные повторялись в датасете несколько раз, но авторы статьи об этом не упоминают.

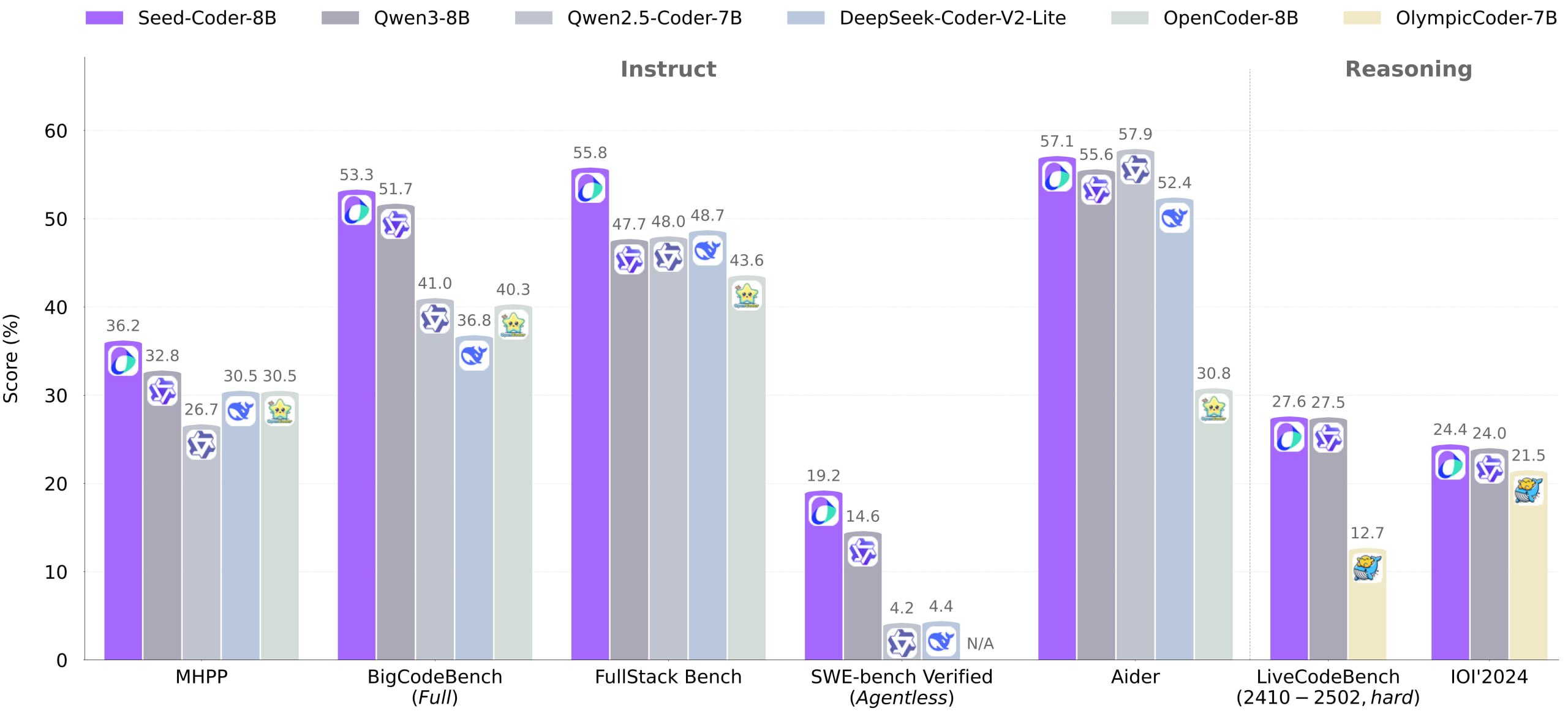

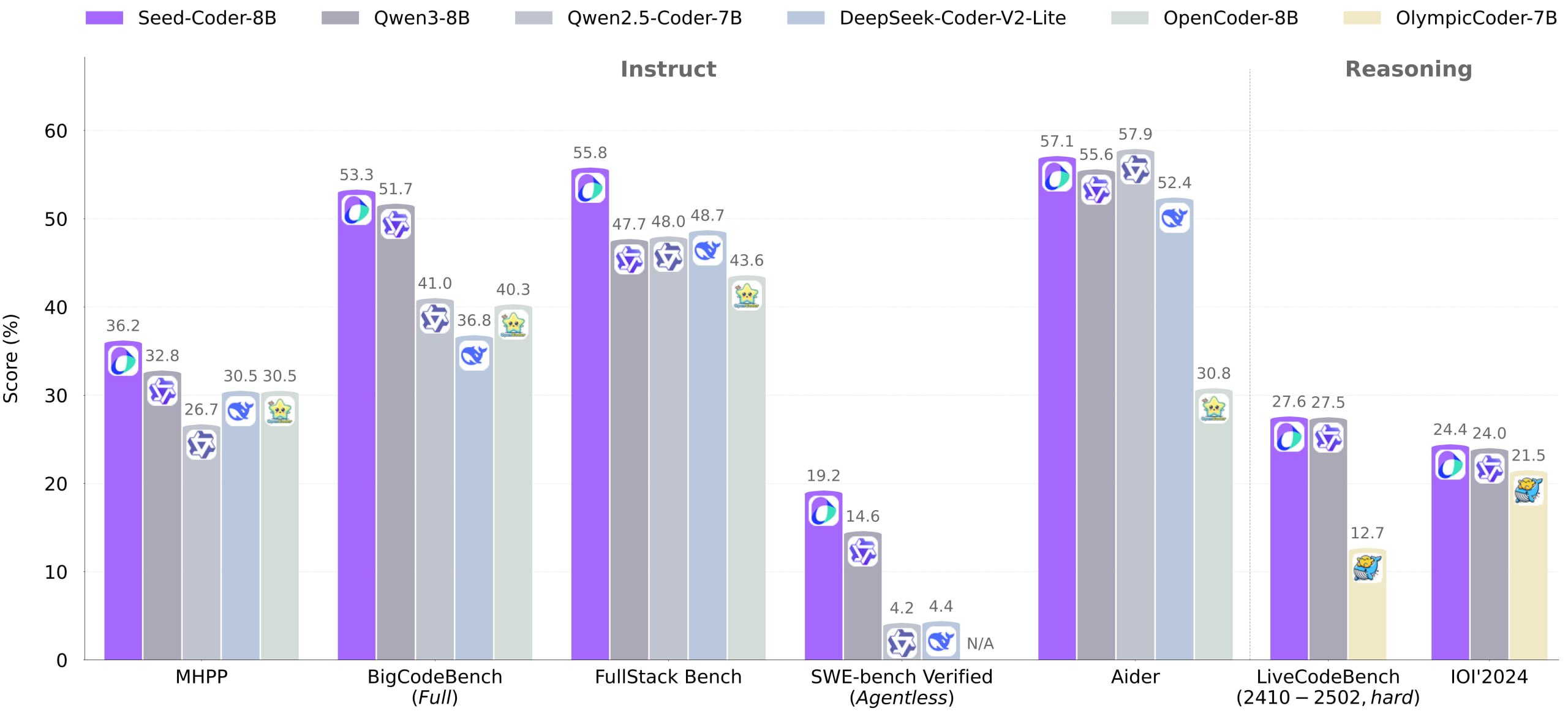

Instruct-версию обучают через SFT (supervised fine-tuning) на синтетических данных, сгенерированных и отфильтрованных LLM, и DPO (Direct Preference Optimization). Модель для логических рассуждений тренируют через LongCoT RL (Reinforcement Learning with Long Chain-of-Thought), чтобы улучшить решение сложных задач. В итоге Seed-Coder превосходит открытые аналоги своего размера на бенчмарках (генерация, автодополнение, ризонинг и т.д.), а иногда и более крупные модели.

Веса моделей доступны по ссылкам: Reasoner / Instruct.

Технический отчет можно найти здесь.

Особенностью является то, что модель обучена всего на 6 триллионах токенов, что относительно мало, учитывая, что датасеты лучших открытых моделей часто превышают 30 триллионов токенов.

Ключевым элементом обучения является "model-centric" пайплайн. Специальные LLM-фильтры оценивают качество кода (читаемость, модульность и другие аспекты) из GitHub и веб-источников, отсеивая примеры низкого качества. Таким образом, отфильтровывается около 2.3 триллиона токенов данных. Затем модель обучается на 6 триллионах токенов, что вызывает небольшое недоумение. Вероятно, некоторые данные повторялись в датасете несколько раз, но авторы статьи об этом не упоминают.

Instruct-версию обучают через SFT (supervised fine-tuning) на синтетических данных, сгенерированных и отфильтрованных LLM, и DPO (Direct Preference Optimization). Модель для логических рассуждений тренируют через LongCoT RL (Reinforcement Learning with Long Chain-of-Thought), чтобы улучшить решение сложных задач. В итоге Seed-Coder превосходит открытые аналоги своего размера на бенчмарках (генерация, автодополнение, ризонинг и т.д.), а иногда и более крупные модели.

Веса моделей доступны по ссылкам: Reasoner / Instruct.

Технический отчет можно найти здесь.